公司每个月烧掉一辆比亚迪秦的 Token 费,财务把 9000 刀的账单甩在 CTO 脸上时,全办公室的空气都凝固了。后端在那纠结是换 GPT-4o mini 还是买 H100 自部署,我默默合上笔记本丢出一句话:“要不,让用户的显卡帮咱算?”

讲真,别一提到 AI 就只知道调 API。现在用户手里那帮 M3 芯片的 Mac、RTX 40 系的游戏本,算力空转着简直是暴殄天物。

我直接祭出了 WebGPU + WebLLM 这套组合拳。说白了,就是把 Qwen2.5 这种级别的模型做 4bit 量化,压缩到几 GB 往浏览器里一塞。

核心逻辑就这几行

别整那些虚的,直接看代码,简单到发指:

import { CreateMLCEngine } from "@mlc-ai/web-llm";

// 选最小且稳定的Qwen2.5,先保证能跑起来

const modelId = "Qwen2.5-0.5B-Instruct-q4f32_1-MLC";

// 初始化引擎(WebGPU)

const engine = await CreateMLCEngine(modelId, {

initProgressCallback: (p) => {

console.log("[MLC]", p.text);

},

});

// 控制台对话

async function ask(text: string) {

const res = await engine.chat.completions.create({

messages: [{ role: "user", content: text }],

});

console.log("🤖", res.choices[0].message.content);

}

// 测试

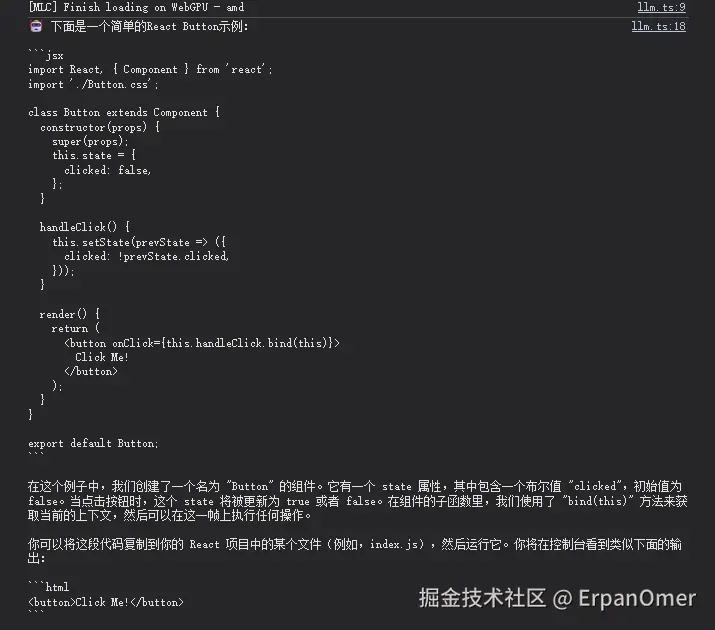

await ask("写一个 React Button")

await ask("用CSS实现三角形")

await ask("用Python写一个冒泡排序")

爽点在哪?

后端组长本来还想看我笑话,结果他在 M1 Mac 上点开 Demo,模型跑起来的一瞬间他直接闭嘴了。

- 速度:生成速度稳在 15 tokens/s 左右。因为是本地计算,根本没有网络延迟,体感比调 GPT-4 接口快得多。

- 成本:除了第一次下载模型的 CDN 流量费,后面全是 0 成本。

- 隐私:数据根本不出浏览器。财务大姐现在敢把各种敏感报表直接喂给 AI 处理了,再也不怕数据泄露到 OpenAI 去。

丑话说在前头 (手动狗头)

这玩意儿也不是万能药,坑还是有的。

首先是首屏加载,几 GB 的模型文件,网速慢点确实能让人等到怀疑人生(建议做持久化缓存)。其次,那些还在用集显老古董的用户,跑起来电脑能直接变身暖手宝,风扇起飞那是常态。

但我个人的态度很明确:在企业内部工具、代码辅助或者离线文档助手这些场景下,Edge AI 绝对是降本增效的核武器。与其苦哈哈地优化 Prompt 抠那点 Token 钱,不如直接压榨用户的 GPU。

现在前端的边界早就不止是画页面了。WebGPU 这一波,直接把我们送进了原生性能的赛道。

大家觉得,这种“分布式白嫖用户算力”的方案,会是未来中小型 AI 应用的主流吗?还是说这只是极客们的自嗨?

评论 0 条

暂无评论,来种下第一颗种子。